Le mardi 20 août, aux environs de 22 heures, le corps sans vie d’Abdou Aziz Ba, surnommé Aziz DABALA, un célèbre danseur originaire de Pikine, a été retrouvé. Gisant à ses côtés, son jeune cousin Waly, tailleur de profession, également assassiné. Depuis lors, ce double meurtre est devenu le sujet de conversation numéro 1 au Sénégal. Cet événement a profondément ému l’opinion publique, surtout lorsque les détails concernant la découverte des corps ont été relayés par la presse.

Les forces de l’ordre mènent activement l’enquête pour identifier les coupables et faire toute la lumière sur ce crime odieux. Cependant, cette enquête officielle est entravée par l’intervention de nombreux « enquêteurs » autoproclamés sur TikTok, déterminés à mener leurs propres investigations. En l’espace de quelques jours, de Tiktok à Youtube, en passant par les sites d’actualité, des théories complotistes ont émergé, accusant des innocents et semant la confusion.

Cet article explore les mécanismes sous-jacents de TikTok qui favorisent la propagation de ces infox, ainsi que les impacts psychologiques sur les utilisateurs.

TikTok, dopamine et désinformation : comment l’algorithme piège les utilisateurs ?

TikTok compte au Sénégal environ entre 4,5 M et 5M d’utilisateurs connectés chaque mois selon des analyses effectuées sur Semrush pour une majorité de femmes ( 60% ). D’après une récente étude de Kantar qui date d’Avril 2024, c’est la deuxième plateforme au Sénégal en termes de consommation soit 63% derrière Whatsapp ( 91% ) et devant Youtube ( 59%) .

Comme d’autres plateformes sociales, c’est un terreau fertile pour les fake news. L’absence de modération stricte et la facilité avec laquelle les utilisateurs peuvent créer et partager des contenus contribuent à la prolifération rapide d’informations non vérifiées. Dans le cas de l’affaire Dabala, cela a conduit à l’accusation injuste de certains individus, montrant à quel point la désinformation peut être dévastatrice. En réalité, l’algorithme de TikTok est conçu pour maximiser l’engagement des utilisateurs en leur proposant du contenu similaire à ce qu’ils ont déjà visionné. Ce mécanisme crée une boucle d’exposition continue, renforçant les croyances des utilisateurs et les poussant à s’engager davantage, même avec des contenus trompeurs.

Tik Tok : une niche de dopamine

Chaque interaction avec une vidéo complotiste augmente la probabilité de voir d’autres vidéos similaires, alimentant une addiction aux contenus sensationnalistes. En outre, l’algorithme de TikTok n’est pas seulement conçu pour garder les utilisateurs engagés ; il exploite également le système de récompense dopaminergique du cerveau. La dopamine est un neurotransmetteur crucial dans le cerveau, souvent associé au système de récompense. Lorsqu’une personne reçoit une récompense, qu’elle soit tangible comme un gain financier ou abstraite comme un like sur une vidéo, son cerveau libère de la dopamine, créant une sensation de plaisir. Sur les réseaux sociaux comme TikTok, ce mécanisme est exploité pour maintenir l’utilisateur engagé. Chaque interaction positive avec une vidéo, que ce soit un like, un partage ou un commentaire, déclenche une libération de dopamine. Ce phénomène incite les utilisateurs à continuer de consommer du contenu, recherchant constamment cette gratification instantanée

Ainsi sur Tik Tok, chaque nouvelle vidéo, chaque nouveau like ou commentaire, déclenche une libération, un pulse de dopamine, rendant les utilisateurs accros à la plateforme. Cette quête de satisfaction instantanée, même inconsciente, pousse les utilisateurs à consommer des contenus sans discernement, amplifiant la propagation des fake news.

Pour comprendre cela, il faut aller en profondeur sur le fonctionnement de l’algorithme Tik Tok : THE LOOP EFFECT

The TIKTOK LOOP effect

L’algorithme de TikTok, souvent désigné comme l’un des plus efficaces pour capter l’attention des utilisateurs, joue un rôle central dans la propagation de la désinformation en raison de son fonctionnement basé sur la personnalisation extrême et la récompense immédiate.

En effet, TikTok utilise un algorithme de recommandation qui analyse minutieusement le comportement de chaque utilisateur : les vidéos qu’ils regardent, likent, partagent, ou commentent. Cet algorithme est conçu pour maximiser l’engagement en présentant du contenu similaire à ce que l’utilisateur a déjà montré de l’intérêt. Il faut également savoir que lorsqu’un utilisateur s’inscrit pour la première fois sur TikTok, l’algorithme ne connaît encore rien de ses préférences.

Pour remédier à cela, TikTok lui présente un ensemble varié de vidéos, “un paquet” couvrant différents sujets et styles. L’objectif est d’observer les interactions de l’utilisateur avec ces contenus : quels types de vidéos il regarde jusqu’à la fin, lesquelles il like, commente, ou partage. En fonction de ces premières interactions, l’algorithme affine rapidement ses suggestions, en se concentrant sur les types de vidéos qui ont retenu l’attention de l’utilisateur. Cette stratégie permet à TikTok de créer une expérience très personnalisée dès le début, augmentant ainsi l’engagement de l’utilisateur sur la plateforme.

Cependant, ce mécanisme peut aussi contribuer à la propagation de désinformation. Si un nouvel utilisateur interagit avec des vidéos contenant de la désinformation ou des théories complotistes, l’algorithme va rapidement lui proposer davantage de contenus similaires. Cela peut entraîner l’utilisateur dans une spirale de désinformation dès ses premiers jours sur la plateforme, renforçant ses croyances erronées.

Ce processus crée ce qu’on appelle une « bulle de filtre » ou « TikTok Loop », où les utilisateurs sont constamment exposés à des vidéos qui confirment leurs croyances ou leurs centres d’intérêt actuels, renforçant ainsi les mêmes idées encore et encore. On parle aussi d’algorithme de conditionnement.

Faisons l’exemple en tapant sur la barre de recherche Tiktok et la barre de recherche Google pour faire des recherches neutres sur la requête “ AZIZ DABALA “.

La recherche sur Google n’est pas aussi alarmante, mais la recherche sur Tiktok nous conditionne déjà sur le type de contenus qui puisse éveiller notre curiosité et attirer notre attention. Il nous propose ainsi des contenus chocs ou spectaculaires et nous conditionne ainsi à aller vers ces recommandations de recherches : “ KOUKO RAY “ CIMETIÈRE” HOMOSEXUEL”

Lorsque des vidéos désinformantes deviennent virales, l’algorithme les pousse à un nombre encore plus large d’utilisateurs, non seulement parce qu’elles suscitent de l’engagement (likes, partages, commentaires), mais aussi parce qu’elles sont jugées pertinentes pour d’autres utilisateurs au comportement similaire. Cela crée un effet de « loop », où la désinformation est continuellement amplifiée, donnant l’impression d’une véracité accrue.

De l’effet LOOP à la boucle virale de désinformation

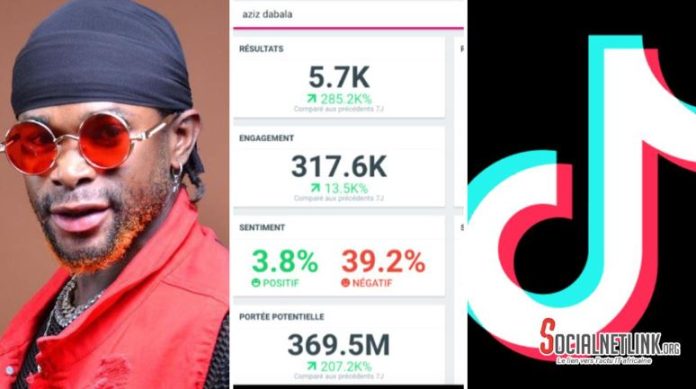

Sur notre outil d’observation et d’analyse des réseaux sociaux, Talkwalker, on peut facilement observer un schéma de propagation. Où la désinformation commence sur TikTok, puis migre vers YouTube, Facebook, et enfin les sites d’actualités. Ce n’est pas un cycle linéaire, mais il peut être appelé boucle virale de désinformation ou cascade de désinformation multiplateforme. Voici les étapes observées :

Initiation sur Tik Tok :

TikTok, avec son effet loop qui favorise la viralité rapide. Les contenus sensationnalistes y trouvant un terrain fertile, les utilisateurs, souvent jeunes et enclins à partager des vidéos qui provoquent des émotions fortes, sont les premiers relais de la désinformation.

Propagation et accélération rapide sur X ( ex Twitter ) :

Sur Twitter, les informations provenant de TikTok peuvent rapidement être relayées par des utilisateurs influents ou des comptes avec de nombreux abonnés. Grâce à la nature succincte et rapide de Twitter, une rumeur ou une fausse information peut être retweetée des milliers de fois en quelques heures, augmentant considérablement sa visibilité.

X fonctionne également comme une chambre d’écho, où les utilisateurs suivent souvent des comptes qui partagent leurs croyances. Une fois que la désinformation s’est propagée sur Twitter, elle a tendance à être amplifiée par des groupes de personnes partageant les mêmes idées, renforçant la polarisation et solidifiant les croyances erronées.

Amplification sur YouTube:

YouTube, avec ses vidéos plus longues et ses algorithmes de recommandation, permet à ces rumeurs de se développer davantage. Des créateurs ou des médias vont souvent produire des vidéos d’analyse, souvent basées sur des informations non vérifiées issues de TikTok ou Twitter permettant également d’atteindre un public plus large et plus diversifié.

Echo sur Facebook et Whatsapp:

Facebook agira comme une chambre d’écho, où des communautés spécifiques (groupes fermés, pages) partagent ces vidéos YouTube ou créent de nouvelles discussions autour de ces théories. Whatsapp est aussi une plateforme où les générations plus âgées, moins familières avec la vérification de l’information en ligne, peuvent propager ces contenus à un autre public.

Légitimation par les sites d’actualités:

Les sites d’actualités en ligne, souvent en quête de clics, peuvent reprendre ces rumeurs sous prétexte de les démentir ou simplement parce qu’elles sont devenues « virales ». Cela donne une légitimité inattendue à la désinformation, qui passe ainsi de simple rumeur à sujet traité par les médias.

Biais cognitifs et Fake News : l’influence néfaste des créateurs de contenu

Ces 7 derniers jours, plus de 855 uniques auteurs ont créé des contenus sur l’affaire Aziz Dabala sur les réseaux sociaux. Ils sont soit de simples utilisateurs de Twitter, des médias avec un grand audimat, des blogs, des chaines Youtube ou des comptes tiktok de créateurs vivant aussi bien au Sénégal que dans la diaspora. Nous pouvons les diviser en 5 groupes :

Les « Faux enquêteurs »

Cette catégorie crée du contenu pseudo-investigatif en utilisant des indices non vérifiés ou des théories de leur propre invention. Leur objectif est souvent de générer du buzz en jouant sur les émotions des spectateurs. Leur influence est souvent renforcée par les biais cognitifs des utilisateurs, tels que le biais de confirmation, qui les pousse à croire et à partager ces contenus car ils confirment leurs idées préconçues.

Les médias sensationnalistes

Certains médias, souvent en quête de clics et de visibilité, relaient ces informations sans les vérifier rigoureusement. Ces médias peuvent être des chaînes YouTube, des blogs, ou même des sites d’actualités avec une audience importante. Ils contribuent à la diffusion massive des fake news en donnant à ces théories une apparence de légitimité. Ces relais renforcent le biais de disponibilité, où les informations qui sont les plus accessibles ou fréquemment mentionnées sont perçues comme plus crédibles par les consommateurs.

Les « fans » de théories complotistes

Ce groupe est composé d’utilisateurs qui sont déjà conditionnés à croire aux théories du complot. Ils se retrouvent souvent sur les réseaux sociaux où ils partagent et discutent activement de ces théories, contribuant à leur viralité. Ces utilisateurs souffrent souvent de biais de confirmation et d’un biais d’ancrage, où les premières informations qu’ils reçoivent (même si elles sont fausses) influencent fortement leur jugement.

Les amplificateurs de la Diaspora

Ces personnes, souvent basées à l’étranger, si elles ne sont pas créateurs de contenus, ont également une certaine influence auprès de leur entourage et sont enclins à relayer ces informations. Elles peuvent également être motivées par le désir de rester connectés à l’actualité de leur pays d’origine, le Sénégal, mais leur éloignement géographique les rend plus vulnérables à des informations non vérifiées.

Les utilisateurs ordinaires et partageurs involontaires

Il s’agit des utilisateurs qui ne produisent pas de contenu original mais partagent, commentent, ou likent les publications qu’ils voient. Ce sont des victimes. Mais ce groupe joue un rôle clé dans la viralité des fake news, car chaque interaction avec le contenu désinformant renforce sa diffusion sur les plateformes. Leur comportement est souvent guidé par un biais d’autorité (où ils font confiance aux créateurs de contenu populaires ) et un biais de confirmation.

En résumé, les biais cognitifs jouent un rôle crucial dans la façon dont les utilisateurs perçoivent et partagent les informations sur Tik Tok. Le biais de confirmation, par exemple, pousse les gens à rechercher des informations qui confirment leurs croyances préexistantes. Dans le contexte de l’affaire Dabala, ce biais a conduit de nombreux utilisateurs à croire aux théories les plus extravagantes, simplement parce qu’elles correspondaient à leurs craintes ou à leurs opinions. En plus, certains créateurs de contenu sur TikTok ont un pouvoir d’influence énorme, capable de façonner l’opinion publique surtout devant une audience jeune ou parfois illettrée. Malheureusement, dans des cas comme celui de l’affaire Dabala, ce pouvoir peut être utilisé de manière irresponsable, amplifiant la désinformation et causant des dommages irréparables à la réputation d’individus innocents.

Conclusion :

L’affaire Aziz Dabala est un triste rappel des dangers de la désinformation sur les médias sociaux comme Tik Tok. Alors que l’enquête continue dans le monde réel, il est crucial que les utilisateurs des réseaux sociaux adoptent une approche plus critique de la consommation de contenu et que les plateformes elles-mêmes renforcent leurs mécanismes de modération pour empêcher la propagation de fake news.

Il est également légitime que l’État du Sénégal prenne des mesures pour inciter ces plateformes comme Facebook, Youtube, Twitter, et TikTok à agir de manière responsable en imposant des obligations claires pour lutter contre la désinformation. Il ne s’agit pas de censure, mais cela pourrait inclure l’introduction de régulations spécifiques, des partenariats avec des fact-checkers locaux, et une transparence accrue sur les algorithmes qui favorisent la viralité des contenus. Seule une action concertée entre les utilisateurs, les plateformes, et les autorités pourra freiner l’impact négatif de la désinformation sur notre société.

L’information est la plus grande arme aujourd’hui dont disposent les Etats. Les stratégies de contournement de l’opinion sont aujourd’hui des “armes fatales” pour les entreprises et les gouvernements. Au-delà de la désinformation, il est crucial de reposer sur la table, le problème de la collecte des données par ces GAFAM.

Mahtarus.

Digital Strategist.

Avec Socialnetlink